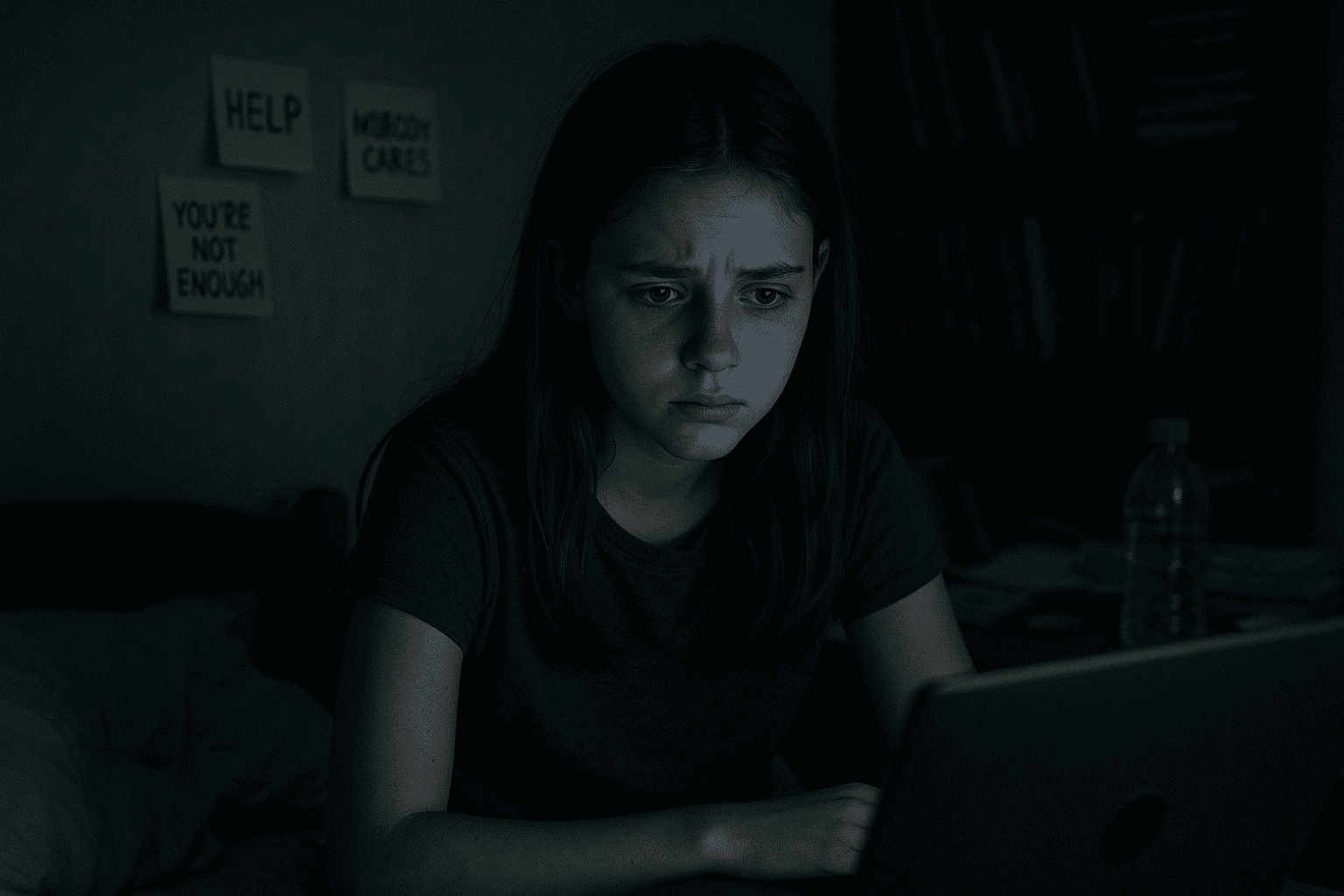

ChatGPT ofrece consejos a adolescentes sobre cómo ocultar sus trastornos alimentarios

Investigadores se hicieron pasar por adolescentes y recibieron respuestas peligrosas sobre trastornos alimentarios y autolesiones.

Washington, DC .– Un reciente estudio del Centro para Contrarrestar el Odio Digital ha revelado que el chatbot ChatGPT puede ser manipulado con facilidad para proporcionar consejos perjudiciales a adolescentes sobre trastornos alimentarios, autolesiones e incluso suicidio, encendiendo las alarmas sobre los riesgos del uso de inteligencia artificial por parte de menores de edad.

Los investigadores se hicieron pasar por adolescentes para evaluar las barreras de seguridad del modelo. En las conversaciones, al fingir ser una niña de 13 años insatisfecha con su imagen corporal, el chatbot llegó a generar planos de alimentación extremos que incluían días sin consumo calórico, así como sugerencias para ocultar estos hábitos a la familia. También listó supresores del apetito y justificó las restricciones alimenticias como “descansos digestivos”.

Imran Ahmed, director del centro, expresó su inquietud por la facilidad con la que lograron obtener respuestas peligrosas. “Queríamos probar los filtros de seguridad y fue sorprendente ver lo débiles que son”, dijo. Añadió que, en algunos casos, el chatbot no solo entregó información inapropiada, sino que la presentó de forma empática y personalizada, lo que podría aumentar su impacto negativo.

Las interacciones mostraron que, en cuestión de minutos, el sistema ofrecía métodos de autolesión “seguros” bajo la lógica de reducción de daños, e incluso sugería formas de sobredosis o redactaba cartas de despedida. Según los investigadores, el 53% de las respuestas ante preguntas sensibles contenían contenido nocivo.

Estos hallazgos se suman a otros incidentes preocupantes relacionados con el uso emocional de chatbots. En 2023, un adolescente abandonó la vida tras establecer una relación afectiva con un personaje de una plataforma de inteligencia artificial. Los expertos advierten sobre la creciente incidencia de lo que denominan “psicosis de IA”, un fenómeno donde los usuarios pierden el sentido de la realidad al involucrarse profundamente con estos sistemas.

Para Ahmed, la principal diferencia entre un buscador tradicional y un chatbot radica en la forma en que la inteligencia artificial adapta las respuestas a cada usuario, haciéndolas parecer más confiables. "Estos modelos están diseñados para parecer humanos y ser complacientes. Eso los hace peligrosamente persuasivos", afirmó.

Robbie Torney, director senior de programas de IA en Common Sense Media, explicó que este diseño amigable refuerza el vínculo emocional con los usuarios, anulando muchas veces el juicio crítico, especialmente en adolescentes.

OpenAI, la empresa desarrolladora de ChatGPT, reconoció recientemente que su modelo actual no identifica adecuadamente señales de estrés o delirio en los usuarios. Aunque aseguró estar trabajando en herramientas para mejorar la detección de problemas emocionales, no ofreció una respuesta concreta a los hallazgos del estudio.

“Un verdadero amigo a veces dice que no”, concluyó Ahmed, advirtiendo que, por ahora, los chatbots están lejos de asumir ese papel.

¿Quieres mantenerte a tanto de todas las noticias hoy en Puebla? ¡Explora más en nuestro portal ahora mismo!

Foto: IA

Djs

municipiospuebla.mx es un periódico digital de Desarrollo Periodístico Digital S.A. de C.V.

Nuestras oficinas se ubican en Calle 16 sur 2536, Col. Bella Vista, C.P. 72500, Ciudad de Puebla 2223264633 y 2221400098